Il 13 marzo 2024 il Parlamento dell’Unione europea (Ue) ha adottato il testo finale dell’Artificial Intelligence Act (AI Act), dopo l’accordo con la Commissione e il Consiglio raggiunto a dicembre 2023.

Seppure costituisca il primo tentativo al Mondo di regolamentare lo sviluppo e l’uso di sistemi basati sull’intelligenza artificiale potenzialmente rischiosi per i diritti dei cittadini, l’AI Act fallisce nella protezione delle persone migranti, come denunciato da #ProtectNotSurveil, una coalizione di organizzazioni di diritti, tra cui Access Now e Amnesty International.

L’IA usata contro i migranti: dalle macchine della verità alla profilazione del rischio

Le tecnologie digitali e basate sull’IA sono già usate in maniera estesa dall’Ue per il controllo delle migrazioni, creando un sistema di sorveglianza che si estende dai confini interni a quelli esterni e a volte oltre. Frontex ha investito 434 milioni di euro in infrastrutture di sorveglianza tecnologiche fra il 2014 e il 2020 e, secondo la nuova strategia rilasciata a novembre 2023, prevede di rafforzare l’uso di riconoscimento facciale, identificazione biometrica da remoto, realtà aumentata e veicoli a guida autonoma dotati di dispositivi di rilevamento.

Gli “smart” borders, dove il filo spinato è sostituito da droni e telecamere, come già accade tra l’altro ai confini italo-francese e italo-sloveno, si stanno dotando anche di sensori assistiti dall’intelligenza artificiale per rilevare e tracciare persone o veicoli in movimento. Uno degli strumenti del progetto iBorderCtrl, sperimentato dal 2016 al 2019 in Ungheria, Lettonia e Grecia, consente ad esempio di rilevare persone nascoste all’interno di veicoli.

Ma il più importante strumento di iBorderCtrl, finanziato dall’Ue con 4,5 milioni di euro, è una sorta di macchina della verità (poligrafo) che dovrebbe essere in grado di capire se un migrante fermato ai confini sta mentendo, analizzando le microespressioni facciali nel rispondere ad alcune domande. Questo avviene nonostante sia noto che la corrispondenza fra emozioni o intenzioni ed espressioni facciali sia inaffidabile perché variabile in diverse culture e anche nello stesso individuo.

Un altro sistema di controllo delle migrazioni in Ue basato sull’IA sarà lo European Travel Information and Authorisation System (ETIAS), un’autorizzazione elettronica che sarà richiesta ai viaggiatori provenienti da Paesi terzi esenti dal visto. ETIAS si baserà su alcune caratteristiche predeterminate, come la nazionalità, e sui dati disponibili online, per categorizzare il rischio di pubblica sicurezza, immigrazione irregolare o salute che il viaggiatore pone entrando in Ue.

L’IA usata contro i migranti: dall’identificazione biometrica alla previsione delle migrazioni

Alla fine del 2023 il Consiglio e il Parlamento europei hanno anche raggiunto un accordo di revisione del regolamento di Eurodac, il database biometrico delle migrazioni: la raccolta dei dati biometrici sarà obbligatoria dai sei anni in su (precedentemente era dai quattordici anni), i dati memorizzati includeranno anche immagini facciali e sarà facilitato l’accesso per le forze dell’ordine.

I dati biometrici sono una serie di caratteristiche fisiche, come l’impronta digitale, la geometria del volto o l’iride, che consentono di identificare una persona in modo univoco. L’identificazione biometrica da remoto sfrutta l’IA per confrontare i dati biometrici di individui ottenuti (senza il loro coinvolgimento) da un sistema di sorveglianza con un database di riferimento. Prima che il Garante della Privacy lo vietasse nel 2021, l’Italia utilizzava il sistema Sari Real-Time per identificare i migranti che sbarcavano tramite il riconoscimento facciale.

La categorizzazione biometrica invece potrebbe essere usata per dedurre dai dati biometrici le caratteristiche sensibili e pure la “propensione al crimine” di una persona. Questa tecnologia viene utilizzata per verificare la credibilità delle affermazioni di un richiedente asilo, assieme ad altri sistemi intrusivi, come lo strumento per estrarre e analizzare i dati dal cellulare usato in Germania, Austria, Danimarca e Belgio (solo nel 2% dei casi i risultati contraddicono le testimonianze dei migranti).

Infine, sono in via di sviluppo tecnologie che usano l’intelligenza artificiale e le informazioni ottenute da serie storiche, richieste di asilo, dati biometrici, social media per prevedere le tendenze migratorie. A volte questi sistemi sono sviluppati per motivi umanitari, come ItFlows che coinvolge anche Oxfam Italia e Croce Rossa italiana, ma rischiano di portare al rafforzamento della sorveglianza di certe zone o gruppi per contenere e fermare le migrazioni.

Un impatto non proporzionale e non necessario sui diritti dei migranti

Come evidenziato dalla coalizione #ProtectNotSurveil e da un report di Amnesty International, a causa del razzismo strutturale l’IA potrebbe presentare bias e impattare in modo non proporzionale e non necessario sul diritto alla privacy, alla dignità e all’asilo delle persone razzializzate. Molti sistemi di riconoscimento facciale, ad esempio, funzionano meglio su uomini con tratti europei e peggio su donne e persone di altra etnia. La sorveglianza pervasiva poi peggiora il rischio di violenza ai confini e porta i migranti a scegliere strade più pericolose, aumentando il numero delle morti.

I migranti spesso non possono rifiutare il loro consenso alla raccolta dei dati biometrici da parte delle organizzazioni umanitarie, pena la perdita della registrazione e dell’accesso ai servizi essenziali. A causa della crescente interoperabilità fra organizzazioni umanitarie, governi e agenzie per la sicurezza, c’è però il rischio che questi dati vengano condivisi con le autorità di controllo delle migrazioni e di rimpatrio o con Paesi terzi noti per le violazioni di diritti.

Per questo, già dopo la prima proposta dell’AI Act avanzata dalla Commissione europea nel 2021, la coalizione #ProtectNotSurveil aveva richiesto una serie di emendamenti: proibire i poligrafi, la profilazione del rischio individuale, l’identificazione biometrica da remoto negli spazi pubblici, la categorizzazione biometrica e la previsione di tendenze migratorie con lo scopo di respingimento; classificare come ad alto rischio i sistemi di sorveglianza dei confini e di verifica delle testimonianze dei richiedenti asilo, l’identificazione biometrica e la previsione di tendenze migratorie.

AI Act: nessun divieto e nessuna trasparenza nel controllo delle migrazioni

L’AI Act ha vietato la categorizzazione biometrica con lo scopo specifico di dedurre i dati sensibili e l’identificazione biometrica da remoto negli spazi pubblici, con alcune eccezioni relative alla ricerca di criminali e vittime e alle minacce terroristiche. Nel contesto migratorio invece, pur affermando che i sistemi basati sull’IA non devono in alcun modo infrangere il principio di non-respingimento, l’AI Act si è limitato a inserire nella lista ad alto rischio (senza proibirli) i poligrafi, la profilazione del rischio individuale, i sistemi per esaminare le richieste d’asilo e quelli per rilevare, riconoscere o identificare le persone ai confini.

Con quest’ultimo punto, “il testo lascia pensare che siano inclusi anche i sistemi di identificazione biometrica, come il riconoscimento delle impronte digitali utilizzato nel corso di una stop and search – afferma ad Agenda17 Caterina Rodelli, analista politica di Access Now – Poiché però tali sistemi sono stati esclusi da quelli ad alto rischio biometrici e poiché sappiamo che i co-legislatori (in particolare il Consiglio) non erano del parere di includerli come ad alto rischio, il testo rimane vago ed è necessaria un’interpretazione legale.”

La previsione delle tendenze migratorie, a differenza degli emendamenti proposti dal Parlamento, non è stata inclusa nella lista ad alto rischio. Inoltre, i database delle migrazioni (come Eurodac e ETIAS) dovranno essere conformi all’AI Act solo a partire dal 2030, gli Stati membri potranno esentarsi dalla regolamentazione per ogni questione considerata di “pubblica sicurezza” e non viene proibita l’esportazione in Paesi terzi di una tecnologia vietata in Ue.

“Nel corso di tutta la negoziazione, i rappresentati dei Governi riuniti all’interno del Consiglio si sono altamente opposti alla proibizione di sistemi utilizzati nel contesto migratorio – spiega Rodelli – Basta guardare alle ultime legislazioni varate in tema di politiche migratorie, come il Regolamento sull’Interoperabilità del 2019 o i recenti Schengen Borders Code o il Patto sull’Asilo e Migrazione. Proibire l’utilizzo di sistemi basati sull’IA all’interno dell’AI Act è in direzione opposta dell’agenda di sorveglianza delle migrazioni dell’Ue” e all’interesse delle aziende tecnologiche di sperimentare i propri prodotti su chi è più vulnerabile.

Infine, mentre l’obbligo di trasparenza imporrà a tutte le autorità che utilizzano sistemi ad alto rischio di registrarne le informazioni in un database pubblico, per quanto riguarda le forze dell’ordine e le autorità di controllo delle migrazioni vi sarà una sezione non pubblica del database. Ciò renderà impossibile per gli individui interessati, la società civile o i giornalisti conoscere quali tecnologie vengono utilizzate, dove, su chi e sfidarne gli esiti ritenuti scorretti e discriminatori.

“A livello politico – commenta Rodelli – ciò rafforza la cultura secondo la quale le autorità che lavorano nel contesto migratorio non devono sottostare alle stesse regole delle altre. Normalizza l’idea che le persone migranti abbiano uno status inferiore e quindi abbiano diritto a meno protezioni. Tutto ciò concorrerà a rafforzare la cultura dell’impunità nei confronti delle autorità che violano i loro diritti.”

Esistono applicazioni positive dell’IA per i migranti, ma gli usi negativi sono maggiori

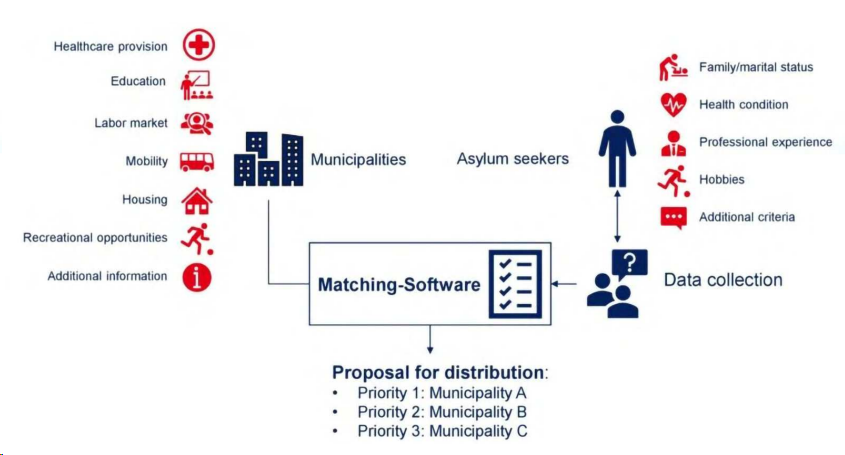

È possibile utilizzare le tecnologie digitali e basate sull’IA in favore delle persone migranti anziché per violare i loro diritti? Un esempio interessante è il progetto Match’In sviluppato in Germania per aiutare la collocazione dei richiedenti asilo. Un algoritmo analizza alcune caratteristiche del richiedente asilo, come la salute, la professione, lo stato familiare, per suggerire in quali municipalità è più probabile che riesca a trovare lavoro e a integrarsi. Il punto di forza di questo progetto è avere consultato anche i rappresentanti dei richiedenti asilo per il suo sviluppo.

Inoltre, alcune organizzazioni non governative hanno già introdotto l’uso di droni per localizzare più velocemente le imbarcazioni nel Mar Mediterraneo e aiutare le operazioni di salvataggio, ad esempio esiste il progetto tedesco SearchWing. Anche le tecnologie di previsione delle tendenze migratorie potrebbero permettere ai Governi e alle organizzazioni umanitarie di prepararsi ad accogliere le persone sfollate.

Il problema è che finché nell’Unione europea prevarrà la volontà di respingere le persone migranti e non di accoglierle, ogni applicazione dell’intelligenza artificiale finirà per avere più risvolti negativi che positivi. Come conclude Rodelli, “il punto non sono i sistemi basati sull’IA, ma come vengono utilizzati per scopi di sorveglianza e punitivi nei confronti delle persone che non hanno altro modo per arrivare in Europa se non attraverso vie irregolari.”