Di recente il gruppo Facebook, di cui fa parte l’omonimo social network, ha annunciato il suo cambio di nome in “Meta”. Tra i motivi del cambiamento molti critici intravedono la volontà di risollevarsi dallo scandalo seguito alla pubblicazione dei Facebook Papers, documenti interni che gettano ombre sulla gestione dei contenuti e sul trattamento dei dati degli utenti. Ma come funziona davvero il meccanismo che determina cosa pubblicare e, soprattutto, cosa censurare?

Ogni contenuto pubblicato sul Web può essere sottoposto a revisione ed eventuale rimozione su segnalazione degli utenti stessi o attraverso l’intervento degli algoritmi. Il ricorso all’intelligenza artificiale è sempre più esteso e diventa inevitabile nella gestione di piattaforme che ormai vantano quantità di utenti e interazioni tali da rendere impossibile il solo controllo manuale.

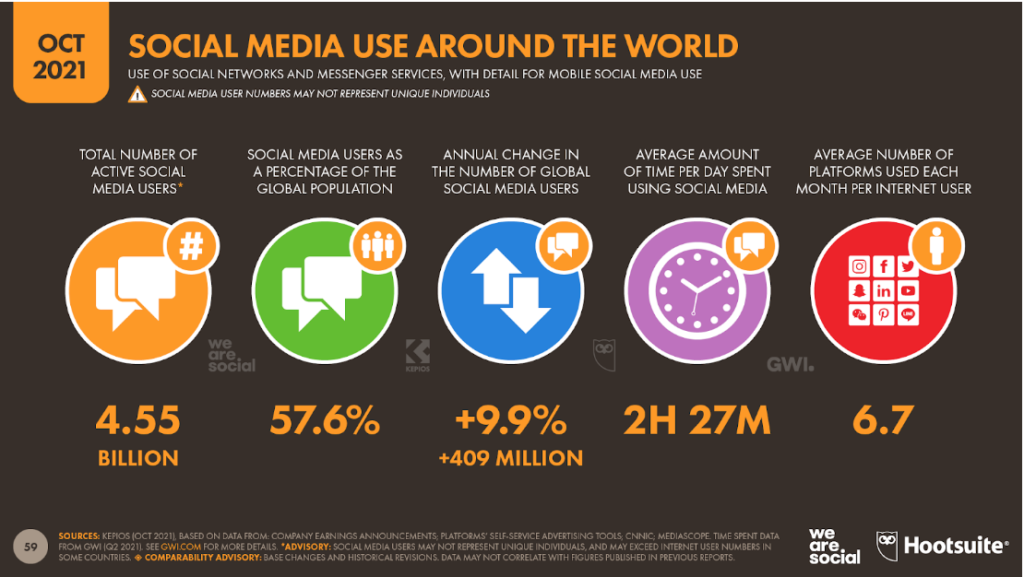

Secondo l’ultimo report Digital 2021, gli utenti totali delle piattaforme digitali sono infatti circa 4,55 miliardi, con un incremento del 9,9% nell’ultimo anno, equivalente a più di un milione di persone al giorno. Si tratta del 57,6% della popolazione mondiale, con un trend in continua crescita che vede sul podio Facebook, Youtube e WhatsApp.

Di fatto, questa massiccia diffusione dei social media conduce alla cosiddetta “algocrazia”, cioè una società basata sul dominio degli algoritmi. L’origine del termine algocracy risale al 2006, con la pubblicazione del libro Virtual Migration del docente di sociologia A. Aneesh, che inizialmente lo associava all’ormai totale controllo e gestione del mondo del lavoro da parte dei software.

Col tempo, il termine si è esteso a indicare l’importanza sempre maggiore degli algoritmi in tutta la società e, con essa, i rischi legati alla concentrazione del potere nelle mani di chi li controlla. In particolare, gli algoritmi hanno sempre più assunto un ruolo determinante nel decidere quali contenuti online pubblicare e quali invece rimuovere.

A tal proposito, la nuova disciplina europea del Digital Service Act (DSA) si ispira al principio secondo il quale “ciò che è illecito offline deve essere illecito anche online”. Gli Stati iniziano cioè a percepire la necessità di una più efficace protezione dei diritti degli utenti anche online, per tutelare il delicato equilibrio tra libertà di espressione e regolamentazione delle piattaforme digitali.

Facebook non sempre riesce a moderare l’hate speech

Il sistema utilizzato da Facebook si basa sulla cooperazione tra filtri basati sull’intelligenza artificiale e controllori umani. Il processo di controllo agisce attraverso algoritmi con funzione di primo filtro dei contenuti pubblicati che, se ritenuti inappropriati, viene segnalato a un team di moderatori – spesso operatori di aziende terze – cui spetta la decisione finale sulla rimozione o meno.

Di recente, peraltro, è cambiata anche la politica per individuare e bloccare i profili fake. Il nuovo sistema, chiamato Facebook DEC, prende in considerazione nuovi parametri che hanno permesso di intensificare i controlli ed eliminare milioni di account falsi in poco tempo. Nonostante ciò, il recente caso dei Facebook Papers ha svelato tutta una serie di aspetti di cui sinora si era all’oscuro.

I documenti sono stati resi noti grazie alle rivelazioni di Frances Haugen, una data engineer che è stata manager nel team Integrità Civica di Facebook dal 2019 fino all’inizio del 2020, quando l’unità è stata soppressa.

Turbata dall’esperienza di una sua amica che si era radicalizzata online, prima di lasciare Facebook Haugen ha copiato e salvato enormi quantitativi di documenti interni, poi condivisi con varie testate giornalistiche e con la Securities and Exchange Commission, l’ente federale statunitense preposto alla vigilanza della borsa valori.

Già da un primo esame, molti sono gli aspetti prima sconosciuti ora divenuti di pubblico dominio grazie ad Haugen. Ciò che emerge, ad esempio, da uno studio pubblicato dal Financial Times è il fallimento del tentativo di moderare l’hate speech soprattutto nei Paesi non anglofoni.

Alto rischio per Paesi con democrazie deboli

Da un documento del 2020 si evidenzia il basso numero di moderatori di contenuti in Paesi come Arabia Saudita, Yemen e Libia, ma anche i frequenti errori di traduzione nelle pagine che spiegavano come segnalare contenuti di incitamento all’odio in Afghanistan.

Si tratta di Paesi considerati ad alto rischio per la fragile situazione politica e gli elevati contenuti d’odio che circolano in rete, come accaduto nel 2017 in Myanmar, quando la piattaforma fu accusata di non aver censurato le campagne d’odio e disinformazione che favorirono l’escalation di violenze e persecuzioni nei confronti del gruppo etnico dei Rohingya.

In sostanza, un generale scarso interesse verso il contrasto degli abusi, anche gravi, consumati sulla piattaforma, soprattutto se avvengono in Paesi scarsamente democratici o non in linea con il canone di pensiero liberale occidentale, con casi estremi di agevolazione di traffico di esseri umani e incitamento etnico dalla violenza.

Vi è la conferma di quello che prima era solo un sospetto: il sistema XCheck, un trattamento preferenziale con una moderazione blanda o inesistente riservato a personaggi pubblici e politici.

Ma anche la conferma dell’obiettivo occulto di contrastare un declino nella tendenza di coinvolgimento degli utenti modificando l’algoritmo per conferire priorità alle “interazioni significative” tra gli utenti, polarizzando ed esaltando contenuti estremi e tossici (hate speech).

L’Oversight Board: la “commissione di supervisione” ovvero la corte suprema di Facebook

Per tutelare maggiormente la libertà di espressione, Facebook ha creato l’Oversight Board, il Comitato per il controllo chiamato a confermare o annullare le decisioni sui contenuti pubblicati: cosa lasciare, cosa rimuovere, e perché.

È composto da quaranta membri scelti tra esperti (accademici, magistrati) o leader pubblici (ex politici, attivisti per i diritti umani) provenienti da diverse aree geografiche. Nato nel 2019, il Comitato ha rilasciato le sue prime sei decisioni in merito alla rimozione di contenuti effettuati dalle piattaforme coinvolte a gennaio 2021 e riguardano tutti il tema dell’hate speech.

Il 28 ottobre 2020, inoltre, in un’udienza davanti al Senato degli Stati Uniti, Mark Zuckerberg ha dichiarato che nella prima metà del 2020 sono stati rimossi da Facebook e Instagram oltre 250 milioni di contenuti che violavano le norme della società, tra cui 25 milioni relativi a terrorismo e odio organizzato, quasi 20 milioni che coinvolgono nudità infantile o sfruttamento sessuale e circa 8,5 milioni identificati come bullismo o molestie.

Tuttavia, secondo quanto dichiarato da Haugen, la percentuale di moderazione dei contenuti di incitamento all’odio si attesta solo al 3-5%. Come possono allora intervenire gli Stati per tutelare nello stesso tempo la libertà di espressione e la lotta a fake news e contenuti illegali?

Facebook, nel tentativo di difendersi dalle accuse, ha diramato un comunicato in risposta alle affermazioni di Haugen, nel quale si legge: “ogni giorno i nostri team devono bilanciare la protezione del diritto di miliardi di persone di esprimersi apertamente con la necessità di mantenere la nostra piattaforma un luogo sicuro e positivo.”

Il ruolo del settore pubblico: l’intervento dell’Unione Europea e dell’Italia

Secondo il Garante per la privacy l’attività dell’Oversight Board di Facebook rimane ancora svincolata dal controllo statuale, poiché non risponde alle leggi del Paese nel quale si verifica la violazione ma considera solo gli standard giuridici internazionali.

Il quadro che si delinea vede le piattaforme digitali assorbire sempre di più competenze statali, affiancando alla fornitura di contenuti e servizi anche interventi che ne determinano la trasformazione in soggetti giuridici con potere decisionale nei confronti degli interessi pubblici e dei diritti degli utenti.

Pur giudicando la sua creazione come un passo avanti, infatti, il Garante esprime dubbi nei confronti dell’indipendenza e dell’efficacia del Comitato, nato per iniziativa della stessa piattaforma che deve controllare e che, quindi, appare più come una “auto-legittimazione” del suo operato.

Strumenti concreti contro la disinformazione

Sul fronte della prevenzione è nato l’European Media and Information Fund, un’iniziativa finanziata con fondi pubblici e donazioni private nata per sostenere il lavoro di ricercatori, fact-checker, organizzazioni no profit o d’interesse pubblico che lavorano sulla ricerca sulla disinformazione e sull’alfabetizzazione mediatica.

La mission è quella di rendere disponibili informazioni oggettive e verifiche delle fonti da cui provengono, per sviluppare una coscienza critica, diffondere un’informazione completa e corretta, al servizio anche degli organi di informazione e degli stessi giornalisti affinché valutino l’attendibilità di fonti e notizie.

Tutte le innovazioni in cantiere, sia sul piano organizzativo interno sia di regolamentazione pubblica, avranno un notevole impatto sul destino delle piattaforme.

Il principio informale “se esageri ti cancello” sarà applicato ancora dai gestori della piattaforma, anche se all’utente saranno riconosciuti nuovi e più efficaci modi per tutelarsi. La nuova strada che l’Unione Europea sta provando a tracciare con le proposte di regolamento, rappresenta solo l’inizio di un lungo percorso.